實驗原理

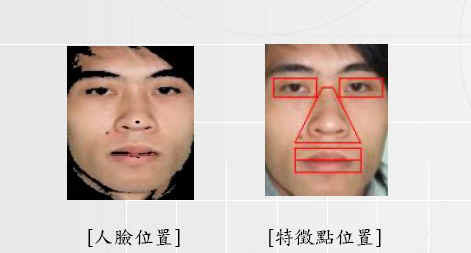

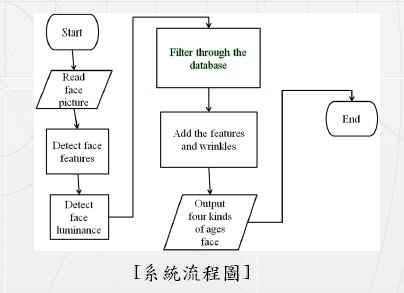

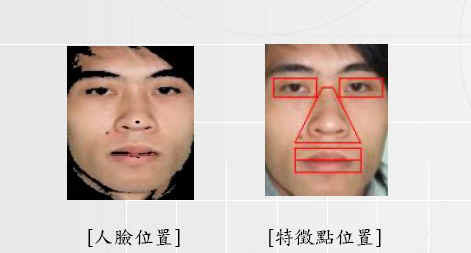

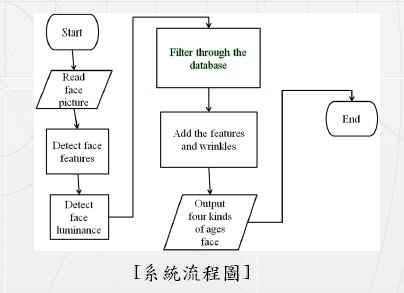

我們的系統大致上可以分為兩個部分,一部分為偵測臉部和臉上特徵點位置,另一部分為將特徵點與資料庫比對以及貼上的技術。 第一部分首先偵測整張照片膚色的部分,也就是臉的位置,將整張圖由RGB轉換成HSV色彩模式,而人臉的膚色點將會在此範圍中:0°<H<50°, 0.2 < S < 0.68, 0.35 < V < 1 ,找到人臉範圍後,接著偵測人臉上的各特徵點,一樣是根據膚色值的範圍,先取出大概之位置,接著一行一行掃描每個pixel值,就可以得到精確的特徵點位置以及形狀。

第二個部分則是做比對以及貼圖的部分,我們將找到的特徵點與資料庫中各老化特徵點作形狀與顏色的比對,算出兩著的相關係數,再利用相關係數找出最相近的來做為老化後之五官。找出適當之五官後,接下來就是貼圖的部分,我們使用新的色彩空間l α β,而l α β則是從RGB色彩空間轉換而來 得出所採用的l α β色彩空間後,貼圖時我們就直接對原本圖中之各特徵點或是皺紋預定地之l α β值作修改,得出老化的結果。 我們所採用的老化五官主要有兩個來源,一個為FG-NET(http://www.fgnet.rsunit.com/),而另外一個則是我們自己在網路上所找的圖片,大概有300多張,建立出我們所使用的資料庫。